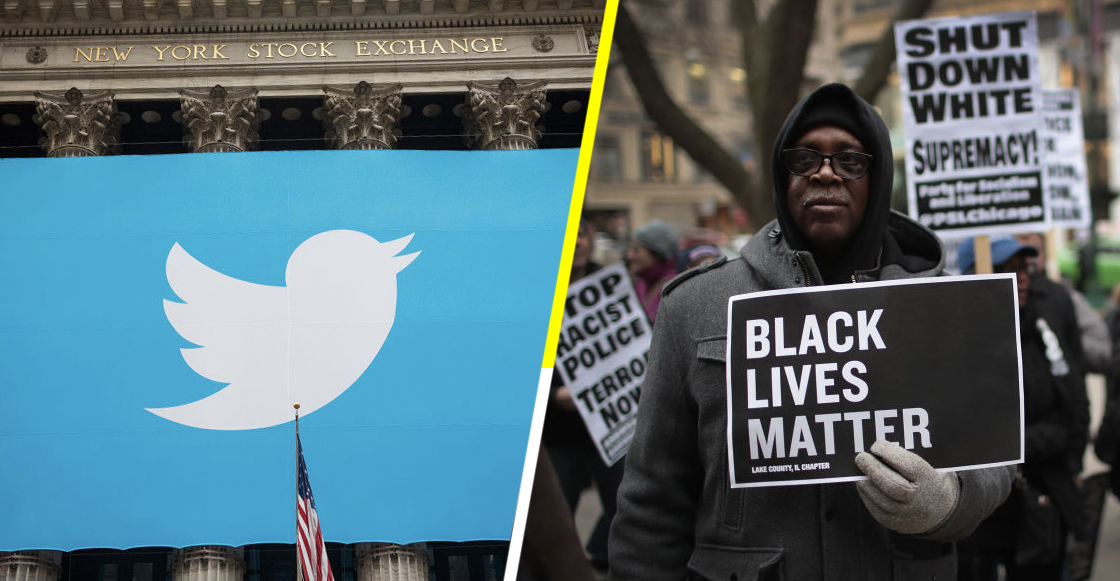

Este 2020 miles de personas en Estados Unidos y todo el mundo tomaron las calles y las redes sociales para exigir que se respetaran los derechos de las personas afroamericanas, esto a través del movimiento #BlackLivesMatter, que evidenció cómo el problema del racismo sigue estando muy presente en la actualidad.

Si bien muchas industrias en el mundo –tales como la del entretenimiento, la música, etc.–, prometieron que serán parte de la solución a esta problemática social, no cabe duda que aún hay muchas cosas por hacer. Sobre todo porque muchas de ellas han sido señaladas de tener un discurso contradictorio en torno al racismo.

Twitter se ha visto envuelto en una polémica sobre racismo

Uno de los casos más recientes fue el que surgió hace unos días con Twitter. Y es que la famosa red social ha sido acusada de tener un algoritmo racista, esto luego de que varios usuarios se percataran de cómo las fotografías posteadas en dicha red social tienen más relevancia si son protagonizadas por personas blancas.

Todo comenzó el pasado 19 de septiembre cuando el desarrollador informático, Toni Arcieri, publicó un hilo de Twitter con un experimento bastante interesante, el cual consistía en postear una imagen larga con dos caras en ella: la de Mitch McConell, líder republicano del senado en EU, y también la de Barack Obama, expresidente del mismo país.

Trying a horrible experiment…

Which will the Twitter algorithm pick: Mitch McConnell or Barack Obama? pic.twitter.com/bR1GRyCkia

— Tony “Abolish (Pol)ICE” Arcieri 🦀 (@bascule) September 19, 2020

Un experimento comenzó a plantear que el algortimo de Twitter podría ser racista

Como seguro muchos saben, Twitter recorta las imágenes que son muy grandes y muestra a los usuarios lo más relevante que hay en ellas. En el caso de las fotos posteadas por Arcieri, el algoritmo daba a entender que Mitch McConell, un hombre blanco, era más relevante que mostrar a Barack Obama, un hombre afroamericano.

“Intentando un experimento horrible … ¿Cuál elegirá el algoritmo de Twitter: Mitch McConnell o Barack Obama?”, escribió el desarrollador en su hilo de Twitter, donde posteriormente subió las mismas fotos pero editadas en contraste o color de piel. Sorpresivamente, Obama sólo aparecía cuando su tono era más blanco.

Let’s try inverting the colors… (h/t @KnabeWolf) pic.twitter.com/5hW4owmej2

— Tony “Abolish (Pol)ICE” Arcieri 🦀 (@bascule) September 19, 2020

These images in particular, comparing low contrast to high contrast Obama, are much more telling. The algorithm seems to prefer a lighter Obama over a darker one:https://t.co/8EAYnYcRs3

— Tony “Abolish (Pol)ICE” Arcieri 🦀 (@bascule) September 21, 2020

Aunque otros creen que no es racismo, sino una cuestión de brillo en las fotos

Varios usuarios de la red social comenzaron a colaborar en este experimento y notaron que incluso el senador Mitch McConell puede ser seleccionado en una imagen donde hubieran más fotos de Obama. Algunos hasta probaron ese punto con fotografías de Michael Jackson antes y después de modificar su color de piel.

Sin embargo, también hubieron otras personas que afirmaron que el algoritmo de Twitter sólo enfoca y prioriza las imágenes que cuentan con zonas o colores más brillantes que otras, por lo cual alegan que no se trataría de un caso de racismo sino de mostrar las zonas más relevantes de una fotografía en cuestión.

More proof: pic.twitter.com/CeCEOTsSJ8

— Him Gajria (@himgajria) September 20, 2020

Isn’t it rather related to the smile (= positivity)? pic.twitter.com/kkEBMJhAxL

— MASCARPOWN (@MASCARPOWN) September 19, 2020

Happens with Michael Jackson too…… pic.twitter.com/foUMcExS2P

— carter (@gnomestale) September 19, 2020

— rat_champ (@rat_champ) September 20, 2020

Twitter ha dado su postura al respecto

Luego de que este experimento se hiciera viral en Twitter y provocara diversas reacciones, el equipo de comunicaciones de la red social dio a conocer su postura a través del mismo medio, afirmando que las características raciales o de género no influyen en su algoritmo. Sin embargo, mencionan que trabajaran en mejorar esta situación.

“Probamos el sesgo antes de enviar el modelo y no encontramos evidencia de sesgo racial o de género en nuestras pruebas. Pero está claro que tenemos que realizar más análisis. Continuaremos compartiendo lo que aprendemos, qué acciones tomamos y abriremos el código para que otros puedan revisar y replicar”, indicó el equipo de Twitter. ¿Qué les parece?

We tested for bias before shipping the model & didn’t find evidence of racial or gender bias in our testing. But it’s clear that we’ve got more analysis to do. We’ll continue to share what we learn, what actions we take, & will open source it so others can review and replicate.

— Twitter Comms (@TwitterComms) September 20, 2020